文|侃科技

今年3月,面對洶涌而來的AI潮,“硅谷刀王”一改往日本色,主動站到臺前,宣布推出DGX云,把AI專用的GPU放到云上「出租」。

以往,出售算力這種事都是云計算公司在干。它們購買多種型號顯卡與人工智能加速器,根據硬件性能或使用時長等方式定價,然后租給下游客戶。

這個過程中,英偉達將GPU要么賣給云計算平臺,要么直接出售給AI公司,比如第一臺NVIDIA DGX超級計算機就是2016年老黃親自交付給OpenAI的,并沒有直接出售算力,頂多算「賣鏟人」。

而DGX上云這個事,雖然英偉達仍需要將其托管到云平臺,但本質上已經是跨越邊界了。

一向屈居幕后的英偉達,這次為何要走向臺前?

本輪AI潮英偉達毫無疑問是最大的受益者,甚至可以沒有之一。

用于訓練AI的GPU芯片價格瘋長,海外A100和H100的每片價格分別漲到了1.5萬美元和4萬美元,國內一臺配置8顆A100和80G存儲空間的AI服務器,價格也從去年中旬的8萬/臺飆升至當前的165萬/臺。

但這些錢并沒有都流入英偉達的口袋,溢價都被渠道拿走了,關鍵是這種倒買倒賣英偉達還一點辦法沒有。

DGX云就在這種情況下應運而生,關鍵價格看似還很便宜。配備8個H100 GPU模組的DGX云,每月套餐費只要3.7萬美元,相當于單片H100的價格。

對于急需算力資金又捉襟見肘的AI公司來說,DGX云無疑是渴睡時天降的一個枕頭;對英偉達而言,出售云算力既能賺錢又綁定了客戶。

而看似雙贏的背后,卻隱藏著一場始于AI的秘密戰爭。

算力平權

從產業特點看,今天基于云算力的AIGC和曾經的加密資產挖礦極其相似,但需要的資源遠高于后者。

國盛證券曾在《Web3 視角下的AIGC算力進化論》中,比較了加密資產挖礦和AIGC產業的異同點:

1、AIGC產業耗電量大約會在1.6-7.5年間超過當前比特幣挖礦產業耗電量,主要驅動因素是GPT類大語言模型在模型參數、日活和模型數量上的高速增長;

2、和比特幣挖礦類似,AIGC產業由算力驅動的內容處于高強度競爭中,參與者只有持續、快速生產出高質量內容,才能保證自己獲取到的用戶注意力不會下降。

這就導致AIGC產業的兩大特點:高成本和持續性。

其中,成本側不止是耗電量,當然耗電量可以作為一個非常直觀的證據。比如百度用于訓練推理文心一言的陽泉超算中心,每小時耗電64000kW·h(度),按照0.45元/kW·h的商業用電標準,一年電費就達到2.5億。

而更大的成本則是來自算力投入。

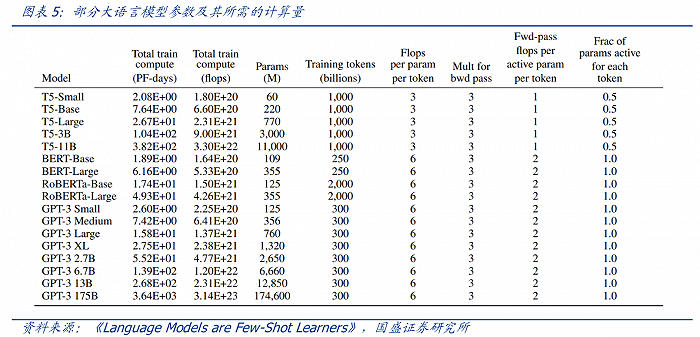

以ChatGPT為例,不考慮與日活高度相關推理過程所需的算力,僅考慮訓練過程,根據測算,1750億參數的GPT-3訓練一次大約需要6000張英偉達A100顯卡,如果考慮互聯損失,大約需要上萬張A100。

按單張A100芯片10萬計算,大規模訓練就需要投入約10億,一般廠商根本承擔不起。而GPT-4的模型參數更大,訓練的標識符更多,所需算力更為可觀。

并且,隨著更多AIGC大模型的發布,其所需算力直線狂飆。

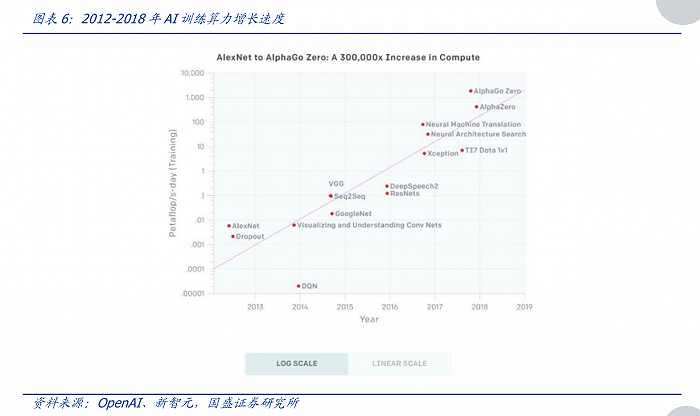

根據OpenAI測算,自2012年至2018年,用于訓練AI所需要的算力大約每隔3-4個月翻倍,總共增長了30萬倍(而摩爾定律在相同時間只有7倍的增長), 每年頭部訓練模型所需算力增長幅度高達10倍,整體呈現指數級上漲。

這個時候就體現出云算力的優勢了,總結下來可以歸結為8個字:化整為零,按需付費。

云算力能讓AIGC大模型廠商無需購買英偉達A100顯卡等硬件,而直接按需租用云算力平臺提供的算力,這使得初創企業或非頭部模型廠商也能嘗試進入AIGC領域。

甚至這種“化整為零”的方式,對產業鏈各方都有益處:

1)對上游算力生產商而言,在算力硬件進入淡季、庫存趨增時,能通過售賣云算力的方式,平滑收入的波動,并為旺季儲備“有生”力量,及時滿足回彈的市場需求;

2)對中游云服務廠商而言,則有助于增加客流;

3) 對下游算力需求方而言,能最大化降低使用算力的門檻,驅動全民AIGC 時代降臨。

如果AIGC大模型廠商愿意讓渡更多資源,還可以更深入地與云平臺合作。這方面的典型案例是微軟云與OpenAI的合作,兩者的合作沒有停留在算力租用上,而深入到了股權與產品的融合。

另外,在大模型競賽中,除了顯性的硬件投入成本,還有一個隱形的時間成本。

一般而言,大模型對于算力的需求分為兩個階段,一是訓練出類ChatGPT大模型的過程;二是將這個模型商業化的推理過程。

而且這個過程越持續大模型就越好。所以現在再來看英偉達DGX云,就不難搞懂老黃干了一件什么事。

用云的方式把用于AI訓練的GPU價格打下來,算力平權籠絡中小公司,再基于大模型訓練的持續性因素綁定客戶,“硅谷刀王”一舉兩得。

受益的未必是英偉達

從去年12月開始,英偉達A100的價格5個月累計漲幅達到37.5%,同期A800價格累計漲幅也達到了20.0%。

GPU價格暴漲無疑增加了AIGC訓練大模型的門檻,但對于頭部廠商而言,漲多少價GPU都是要買的。但對于腰部公司來說,不漲價可能咬咬牙還能下單,一漲價就只能望GPU興嘆了,王慧文創業拿到的5000萬美金融資,可能連訓練所需的顯卡都買不全。

所以,老黃在這個時候拿出DGX云,就像開了一家豪車租賃公司,讓買不起的人也能租用。

當然,這背后英偉達的另一層考量,即搶在競爭對手前面,綁定更多的中小客戶。

本輪AI熱潮中除OpenAI外,最出圈的AI公司非Midjourney和Authropic莫屬了。前者是一款AI繪圖應用,最近同QQ頻道合作開啟了國內業務,后者的創始人則是出自OpenAI,其對話機器人Claude直接對標ChatGPT。

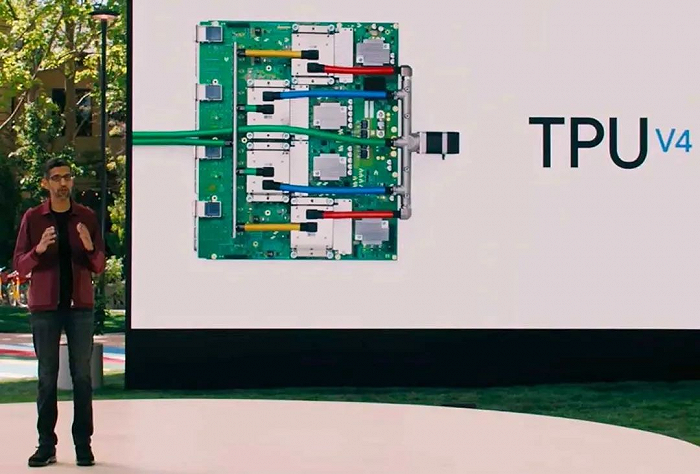

這兩家公司有一個相同點,就是都沒有購買英偉達GPU搭建超算,而是使用Google的算力服務。

該服務由一個集成4096塊TPU v4的超算系統提供,重點是Google自研。

另外一家搞自研芯片的巨頭是本輪AI浪潮的引領者微軟,傳聞這款名叫Athena的芯片采用5nm先進制程,由臺積電代工,研發團隊人數已經接近300人。

很明顯,這款芯片目標就是替代昂貴的A100/H100,給OpenAI提供算力引擎,并最終一定會通過微軟的Azure云服務來搶奪英偉達的蛋糕。

除了云計算公司的背刺,英偉達的大客戶特斯拉也要自己單干。

2021年8月,馬斯克就向外界展示了用3000塊自家D1芯片搭建的超算Dojo ExaPOD。其中D1芯片由臺積電代工,采用7nm工藝,3000塊D1芯片直接讓Dojo成為全球第五大算力規模的計算機。

相較之下,國產芯片可以做對信息顆粒度要求沒有那么高的云端推理工作,但大多目前無法處理超高算力需求的云端訓練。

燧原科技、壁仞科技、天數智芯、寒武紀等公司都推出了自己的云端產品,且理論性能指標不弱。

據此前曝光的信息,百度用于訓練推理文心一言的陽泉超算中心,除了A100還用了一些國產化的產品,比如百度自研的昆侖芯和寒武紀的思元590,其中有消息顯示2023年采購計劃思元大概占10%-20%。

其中,文心一言的芯片層核心能力來自昆侖芯2代AI芯片,其采用自研XPU-R架構、7nm工藝和GDDR6高速顯存,通用性和性能顯著提升;具有256 TOPS@INT8和128 TFLOPS@FP16的算力水平,較一代提升2-3倍。

今年3月,李彥宏也在亞布力中國企業家論壇上分享,昆侖芯片現在很適合做大模型的推理,將來會適合做訓練。

尾聲

從RIVA128開始,英偉達就展示了自己驚人的市場觀察能力。過去的十幾年里,從加密貨幣挖礦到元宇宙,再到AI潮,英偉達順勢將顯卡的客戶從游戲玩家拓展到了科技巨頭。

伴隨著戰火蔓延,英偉達市值也一路高歌,從一個二線芯片公司變成了全行業的No.1。只是,黃仁勛說AI的iPhone時刻已到來,那么諾基亞都被蘋果打敗,英偉達又怎能是無敵的呢。

參考資料

[1] AIGC的看多期權:AI云算力,國盛證券

[2] Web3 視角下的AIGC 算力進化論,國盛證券

[3] 英偉達帝國的一道裂縫,遠川研究所

[4] 云算力挖礦可能是現在入場比特幣最穩的路,Odaily星球日報

[5] 百度“文心一言”專家解讀,獨角獸智庫

[6] 大模型時代,國產GPU加速「狂飆」,數字時氪

[7] 英偉達黃仁勛:將通過中國云服務商提供AI超算能力,AI的iPhone時刻到來! 第一財經

[8] AI算力產業鏈梳理:技術迭代推動瓶頸突破,AIgc場景增多驅動算力需求提升,安信證券